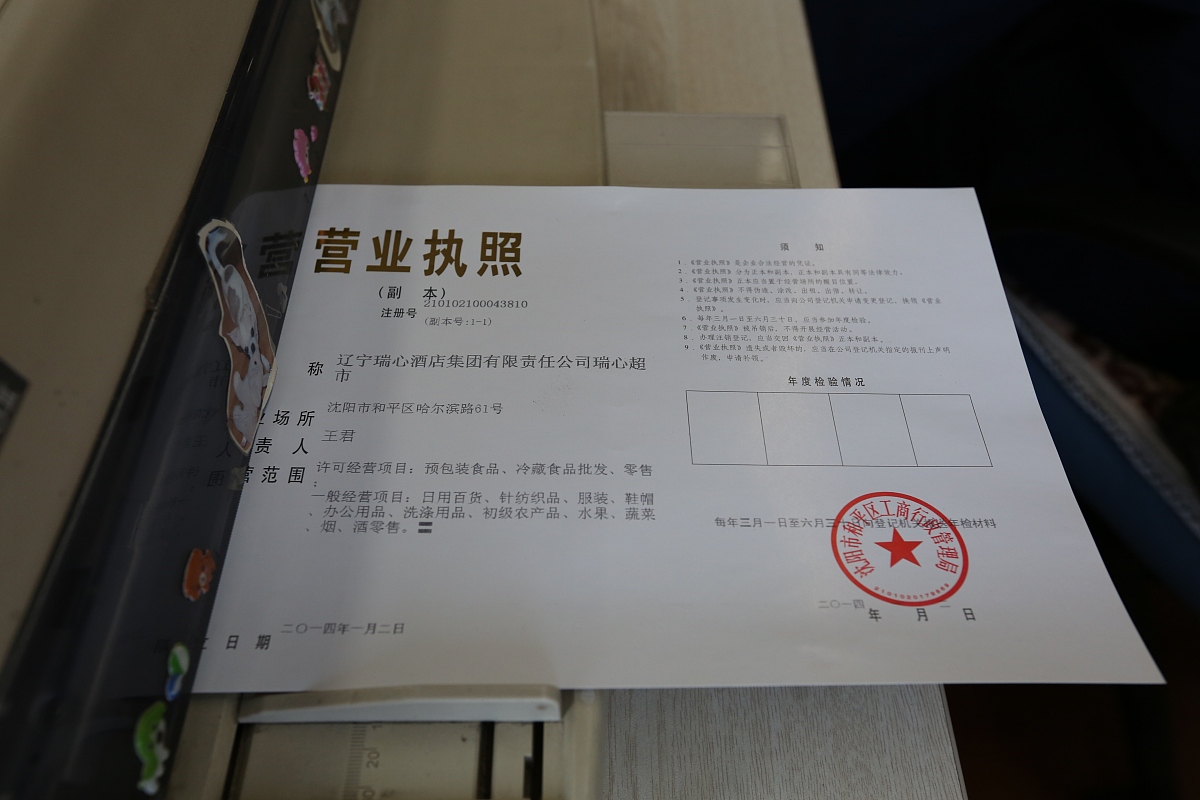

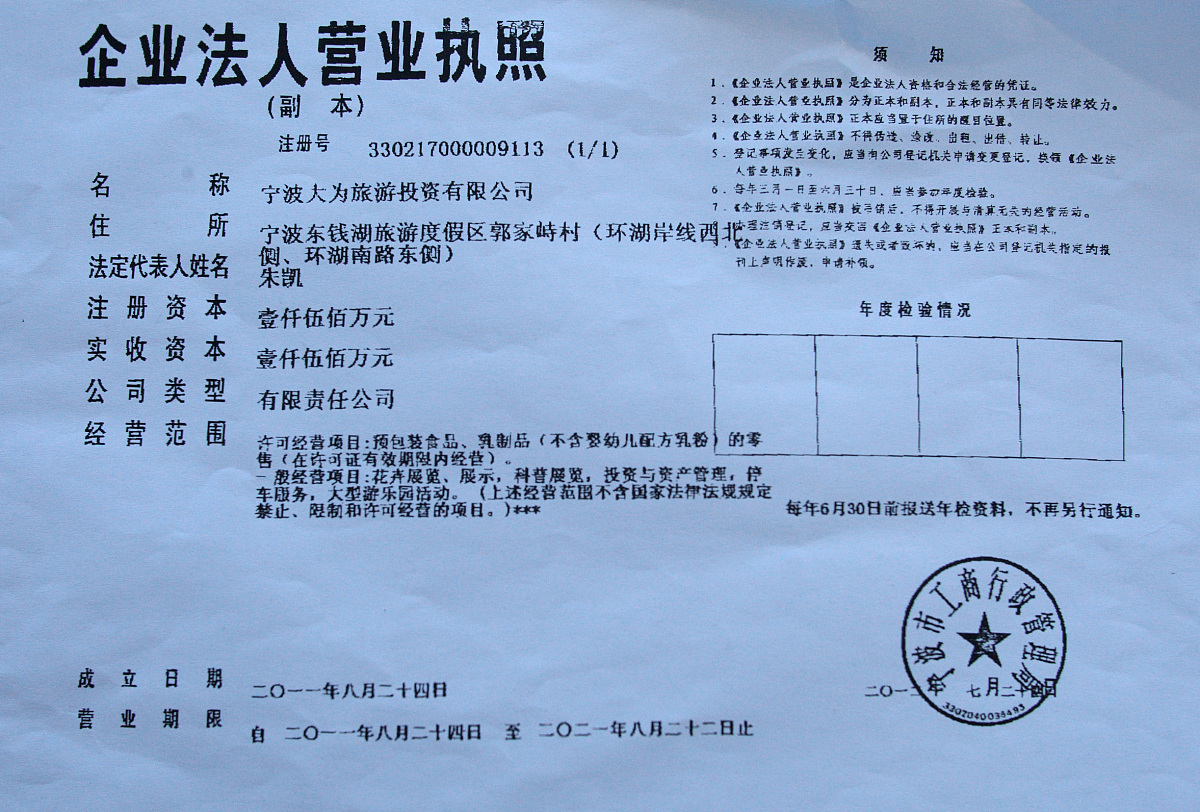

以往,大家经常会存在这样一个误区,认为个体户不需要记账报税。实际上,这是一个非常错误的想法。根据征管法第二十二条规定:从事生产、经营的纳税人应当自领取营业执照或者发生纳税义务之日起15日内,按照国家有关规定设置账簿。这即是说,个体户成立之后,不管有没有经营,开不开具发票,都需要按要求建立账本,记账报税,履行纳税申报义务。所以,对于个体工商户来说,其在日常经营发展过程中,是需要按规定进行记账、报税的

那么,在现实具体操作环节,个体户究竟应该怎么记账、报税呢?

首先,有关个体户记账,其主要分为以下三种情况:(1)对于注册资金10万元以下,每个月的营业额在1万元左右,那么这样的个体工商户确实不需要设置账本,可申请成为定期定额户。(2)对于达到设置简易账要求的个体户而言,其应当设置经营收入账、经营费用账、商品(材料)购进账、库存商品(材料)盘点表和利润表,以收支方式记录、反映生产、经营情况并进行简易会计核算。(3)对于设置复式账的个体工商户来说,应按照《个体工商户会计制度(试行)》的规定设置总分类账、明细分类账、日记账等,进行财务会计核算,如实记载财务收支情况。总体来说,除部分经营规模小的个体工商户之外,广大个体户在日常经营活动期间也是需要按规定进行记账的

其次,有关于个体户报税,其也分为不同的情况。(1)对于没有达到设置账本要求的个体工商户而言,他们可以申请成为定期定额户。所谓定期定额,不是不用缴税,而是按照核定比率缴税。(2)对于申请查账征收的个体户而言,需由纳税人依据账簿记载,先自行计算缴纳税款,事后经税务机关查账核实,如有不符情况,可进行多退少补等。另外,需要说明的是,个体户在报税过程中,其与公司最大的不同是,个体户缴纳经营生产所得税,而企业缴纳企业所得税

可见,根据我国相关政策要求,个体户也是需要按要求记账、报税的。因此,对于有能力自行进行建账、报税的个体户而言,其可根据自身实际经营情况进行账务处理。而对于没有建账能力的个体工商户来说,便可以聘请经批准从事会计代理记账业务的专业机构或者财会人员代为建账和报税,以期实现个体户后续规范、稳定经营发展,并最大限度上确保其财税安全!

【聚禄鼎】一站式企业服务平台

【聚禄鼎】一站式企业服务平台